良質かつ大規模な画像データセットの代名詞でもあるImageNetを使った画像認識コンペティションがImageNet Large Scale Visual Recognition Challenge(ILSVRC)です。

2010年から開催されており2012年にHinton先生らのチームがAlexNetで圧勝し大きな注目集めたのを皮切りに毎年のように新しいモデルが登場しDeep Learning躍進の舞台となったコンペです。

本論文はその名も「ImageNet Large Scale Visual Recognition Challenge」というタイトルでILSVRCの歴史を

- 画像分類(classification)部門

- 位置特定(localization)部門

- 物体検知(object detection)部門

の各部門について

- データセットの構築

- 精度評価指標

- 歴代の上位入賞者のモデル

- モデルの得手/不得手の解析

を網羅的にまとめられており全体で43ページと結構なボリュームとなっています。

ここでは

- 全体編(本記事)

- 画像分類部門編

- 位置特定部門編

- 物体検知部門編

の4つに分けて論文の内容を紹介します。なお、論文はarXivのこちらのページからPDFをダウンロード可能です。

1. イントロダクション

ILSVRCはPASCAL VOC Challengeという画像認識コンペの後継として2010年から開催されておりDeep Learning研究者や有名企業が最新の技術を競う場として大きな注目を集めています。コンペに付随する形でワークショップが開催されており参加者が各自の手法を発表/議論する場にもなっています。

また、コンペで使われるデータは

- 画像単位でのアノテーション: 画像ごとに何が写っているかのラベルを付与

- 物体単位でのアノテーション: 画像中に写っている物体名とその矩形位置を付与

の2つがあります。ともに「ILSVRCデータセット」として公開されており認識アルゴリズムのベンチマークとして有名です。

PASCAL VOCの後継にあたるためコンペの形式など似ている部分も多いのですが

- 画像数: PASCAL VOC 19,737画像 → ILSVRC 1,461,406画像

- クラス数: PASCAL VOC 20クラス → ILSVRC 1,000クラス

と画像数、クラス数ともに大きく増えているのが大きな違いです。

本論文では各部門での「大規模データセットの構築」における苦労点、工夫点をはじめ「モデルの進化」「論文執筆(2014年)時点の認識精度の評価」が解説されています。

2. コンペ部門

コンペで競われる認識タスクとして以下の3部門があります。

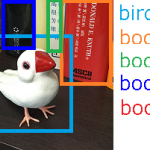

- 画像分類(2010年〜): 画像に写っている物体ラベルを回答

- 位置特定(2011年〜):画像に写っている物体ラベルとその位置を矩形で回答

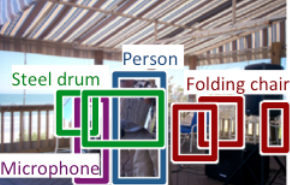

- 物体検知(2013年〜):画像に写っているすべての物体ラベルとそれぞれの物体の位置を矩形で回答

(出典:論文P.16 Figure 7)

という画像に対して画像分類では「Steel drum」という物体ラベルを回答すればよいのですが、位置特定では物体ラベルのほかにその位置

も回答する必要があります。さらに物体検知では写っているすべての物体ラベルと位置

を回答する必要があります。

3. 大規模データセットの構築

各コンペ部門で用いるデータセットを以下の3ステップで構築しています。

- 物体ラベルの定義: ImageNetのカテゴリから選定

- 画像の収集: 物体ラベルごとに検索エンジンを使って収集

- アノテーション: 品質管理に基づいた高品質なラベル付与を実施

特にアノテーションの品質管理については各部門ごとに念入りに設計されており論文中でも多くのページを割いて解説されています。その詳細は各部門編ごとのまとめをご参照ください。

4. 評価指標

認識性能を測る評価指標はPASCAL VOCの評価指標をベースに次の3点を考慮して設計しています。

- 画像分類/位置特定の画像には複数の物体が映り込むことがある点

- 複数の物体が重なりあう場合、物体位置の評価が難しい点

- 物体が数ピクセル程度と小さい場合、物体位置の評価が難しい点

5. 手法

2010年から始まったILSVRCの歴史を振り返っていますが、なんといっても2012年のDeep Neural Network(DNN)の登場がもっともエポックメイキングな出来事でしょう。2011年以前はSIFTなどの画像特徴量をいかにうまく使うかに主眼が置かれていましたが2012年以降はDNNが席巻します。実際、2012年以降は各部門の優勝者はすべてDNNを使っており時代が大きく変わったと言えると思います。

6. 結果の分析

DNNの登場以降も物凄いペースで改良が進み2012年から2014年の2年間で

- 画像分類: エラー率[math]16.4\%[/math]→[math]6.7\%[/math]

- 位置特定: エラー率[math]33.5\%[/math]→[math]25.3\%[/math]

と大きく改善しています。物体検知についても2014年コンペでデータセットが拡充されたため単純な比較はできないものの平均精度(mAP)が[math]22.6\%[/math]mAP→[math]43.9\%[/math]mAPと大きく改善しています。

6章では各部門ごとに認識の得手不得手について分析がされています。具体的には

- 物体ラベルごとの精度

- 画像特性(物体が画像に占める割合)ごとの精度

- 物体特性(実サイズ、変化の多さ、模様の多さなど)ごとの精度

が分析されています。画像特性に関して概ね「物体が占める割合が大きいほど高精度」で、物体特性についても概ね

- 実サイズ: 大きいほど高精度(ただし、位置特定ではあまり差がない)

- 変化の多さ: 多いほど高精度

- 模様の多さ: 多いほど高精度

だと報告されています。

最後に人間の認識精度との比較が行われており2人の被験者(1人は500画像で訓練、もう1人は100画像で訓練)の画像分類のエラー率はそれぞれ[math]5.1\%[/math], [math]12.0\%[/math]だったのに対し2014年の優勝モデルであるGoogLeNetのエラー率は約[math]6\%[/math]とされよく訓練された被験者とほぼ同等の認識性能が出ていることがわかります。

7. 結論

最終章では「教訓」「批判への反論」「今後の課題」がまとめられています。

「教訓」では画像認識という知的なタスクを競うコンペを注意深く設計する必要があったこととデータセットの大規模化をどう進めたのかについて述べています。

「批判への反論」についてはILSVRCに対する

- 物体が画像の中心に大きく写っていることが多く偏りがある

- アノテーションミスが含まれている

- コンペ規約が厳しすぎる

といった批判について反論しています。

最後に「今後の課題」としてはセグメンテーションなどのより高度な画像認識タスクの発展やデータセットさらなる大規模化に向けた取り組みについて触れられています。

関連記事

- AlexNet論文: Deep Learningの火付け役「AlexNet」の発表論文を解説しています。