教師あり学習とは

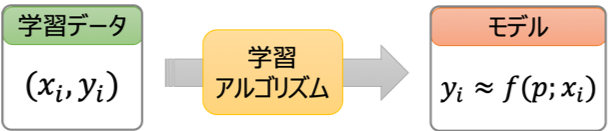

教師あり学習(Supervised Learning)は「入力」と「対応する出力」のデータから入出力関係を求める手法です。一般には[math]N[/math]個の入出力データ

- 入力: [math]n[/math]次元のベクトル[math]\mathbf{x}_i\in \mathbb{R}^n[/math]

- 出力: [math]y_i\in \mathbb{R}[/math]

の組[math](\mathbf{x}_i,\ y_i),\ (i=1,2,\dots,N)[/math]から入出力関係をうまく「近似」する関数[math]f[/math]

[math]

y_i \approx f(p; \mathbf{x}_i)\quad i=1,2,\dots,N

[/math]

を求める問題として定式化されます。

機械学習の分野では

- 入力[math]\mathbf{x}[/math]: 説明変数、特徴量

- 出力[math]y[/math]: 目的変数、ターゲット

- 入出力の組[math](\mathbf{x}_i,\ y_i),\ (i=1,2,\dots,N)[/math]: 学習データ

- 関数[math]f[/math]: 機械学習モデルや単にモデル

- 関数[math]f[/math]やそのパラメタ[math]p[/math]を求める計算方法: 学習アルゴリズム

ここでは代表的な教師あり学習手法とその特徴、性質を紹介します。

線形回帰

線形回帰の考え方

線形回帰は目的変数[math]y\in\mathbb{R}[/math]を説明変数[math]\mathbf{x}\in\mathbb{R}^n[/math]の線型結合で表現するモデルです。

[math]

y = \beta_0 + \beta_1x_1 + \cdots + \beta_n x_n

[/math]

モデルのパラメタ[math](\beta_0,\dots,\beta_n)[/math]を回帰係数と呼びます。各入力[math]\mathbf{x}_i[/math]に対する予測値[math]\hat{y}_i=\beta_0+\sum_k \beta_kx_{k,i}[/math]と出力[math]y_i[/math]の二乗誤差を最小化するように[math](\beta_0,\dots,\beta_n)[/math]を決めます。

[math]

\displaystyle \sum_{i=1}^N \left(\hat{y}_i – y_i \right)^2 \quad \to \quad {\rm minimize}

[/math]

古くから統計学や多変量解析で研究されており教師あり学習の最も基本的な手法です。

単変量線形回帰の性質

説明変数が1つの場合を「単変量線形回帰(Simple Linear Regression)」や「単回帰」と呼びます。理論的に以下のような様々な性質を導くことができます。

- 誤差: 仮定なし

- 考え方と基本的な性質: 回帰係数の導出、回帰直線の性質、計算量との関係

- 決定係数: 決定係数と相関係数の関係

- 予測の留意点: 学習データ外の値や外れ値で予測する場合の留意点と対処法

- 外れ値の影響: 外れ値が学習時に与える影響

- 誤差: 無相関で分散一定

- ガウス・マルコフの定理: 最小二乗推定量は最良線形不偏推定量

- 誤差: 独立同一な正規分布

同様の性質を説明変数が2つ以上の場合にも示せることが多いですが単回帰では結果を簡単に可視化できるため理解しやすいと思います。

多変量線形回帰の性質

説明変数が2つ以上の場合を「多変量線形回帰」や「重回帰」と呼びます。単回帰と同様に様々な性質を理論的に導くことができます。

外挿や外れ値に対する注意も同様に必要ですし、重回帰特有の問題として説明変数間の相関が高いと「多重共線性」と呼ばれる問題が発生し注意が必要です。

- 誤差: 仮定なし

- 考え方と基本的な性質: 回帰係数の導出、回帰超平面の性質、計算量との関係

- 幾何学的な解釈: 重回帰の性質を幾何的に導出

- 決定係数: 決定係数と相関係数の関係

- 多重共線性

- 誤差: 無相関で分散一定

- ガウス・マルコフの定理: 最小二乗推定量は最良線形不偏推定量

- 誤差: 独立同一な正規分布

- 最尤推定量: 最尤推定量は最小二乗推定量と一致。誤差分散に対する不偏推定量を導出。

- 誤差の正規性チェック

- 回帰係数、誤差分散の確率分布: 最小二乗推定量[math]\boldsymbol{\hat{\beta}}[/math]と分散の不偏推定量[math]S^2[/math]の確率分布を導出

- 回帰係数の有意性: 最小二乗推定量[math]\boldsymbol{\hat{\beta}}[/math]の確率分布と有意性検定を導出

- 信頼区間: 真の値の推定値が従う確率分布から信頼区間を導出

- 予測区間: 観測値が従う確率分布から予測区間を導出

機械学習モデルの評価方法

一般に機械学習モデルは未知データで精度が悪化する「過学習」を起こしやすく未知データで性能を測る必要があります。

「機械学習モデルのデータ分割/評価方法」では機械学習モデルを適切に評価するためのデータセットの分割方法を紹介します。