今までは学習データ[math](x_{i,1},\ x_{i,2},\dots,\ x_{i,P},\ y_i)[/math]に確率的な仮定を置かず回帰超平面の当てはめを考えましたが、ここからは確率的な誤差項を含むモデルを考えます。

[math]

Y_i = \beta_0 + \beta_1 x_1 + \cdots + \beta_P x_P + \varepsilon_i

[/math]

ここでは重回帰モデルでもガウス・マルコフの定理が成立し「最小二乗推定量[math]\boldsymbol{\hat{\beta}}[/math]」が「最良線形不偏推定量(Best Linear Unbiased Estimator, BLUE)」になることを示します。

確率モデル

ここでは目的変数[math]Y_i[/math]と説明変数[math]x_i[/math]の間に

[math]

Y_i = \beta_0 + \beta_1 x_1 + \cdots + \beta_P x_P + \varepsilon_i

[/math]

の関係があり誤差項[math]\varepsilon_i[/math]について以下が成立するとします[math](i=1,\dots,N)[/math]。

- 平均: [math]E[\varepsilon_i]=0[/math]

- 等分散性: [math]V[\varepsilon_i] = \sigma^2[/math] ([math]\sigma^2[/math]は未知)

- 無相関性[1]ここでの議論は無相関性を仮定すれば成立し、独立性の仮定は不要です。: [math]Cor[\varepsilon_i, \varepsilon_j]=0\ (i\ne j)[/math]

表記を簡単にするために行列、ベクトルを定義しておきます。

- 説明変数: [math]\boldsymbol{x}=(1,x_1,\dots,x_P)^T\in \mathbb{R}^{P+1}[/math]

- 目的変数: [math]\boldsymbol{Y}=(Y_1,\dots,Y_N)^T\in\mathbb{R}^N[/math]

- 回帰係数: [math]\boldsymbol{\beta}=(\beta_0,\beta_1,\dots,\beta_P)^T\in \mathbb{R}^{P+1}[/math]

- 誤差項: [math]\boldsymbol{\varepsilon}=(\varepsilon_1,\dots,\varepsilon_N)^T\in\mathbb{R}^N[/math]

- 学習データ

- 目的変数の観測値: [math]\boldsymbol{y}=(y_1,\dots,y_N)^T\in\mathbb{R}^N[/math]

- 説明変数の観測値:

[math]

\begin{eqnarray}

\boldsymbol{e} &=& (1,\ 1,\dots,\ 1)^T\in\mathbb{R}^N \\

\boldsymbol{x}_i &=& (x_{1,i},\ x_{2,i},\dots,\ x_{N,i})^T\in\mathbb{R}^N \\

\boldsymbol{X} &=& \left( \boldsymbol{e}\ \boldsymbol{x}_1 \cdots \boldsymbol{x}_P \right)\in \mathbb{R}^{N \times (P+1)}

\end{eqnarray}

[/math]

重回帰モデルは

[math]

\boldsymbol{Y} = \boldsymbol{X}\boldsymbol{\beta} + \boldsymbol{\varepsilon}

[/math]

とかけ誤差項の条件は以下になります。

- 平均: [math]E[\boldsymbol{\varepsilon}]=0[/math]

- 等分散性・無相関性: [math]Cov[\boldsymbol{\varepsilon}] = \sigma^2 \boldsymbol{I}[/math]

ここで[math]Cov[\boldsymbol{\varepsilon}][/math]は分散共分散行列で[math]Cov[\boldsymbol{\varepsilon}]=E[(\boldsymbol{\varepsilon}-E[\boldsymbol{\varepsilon}])(\boldsymbol{\varepsilon}-E[\boldsymbol{\varepsilon}])^T][/math]です。

確率モデルは何が確率変数で何が確定値なのかわかりにくいのでまとめると

- [math]\boldsymbol{X},\ \boldsymbol{y}[/math]: 既知の確定値

- [math]\boldsymbol{\beta},\ \sigma^2[/math]: 未知の確定値

- [math]\boldsymbol{Y},\ \boldsymbol{\varepsilon}[/math]: 確率変数

になります。

このモデルの重要なポイントは説明変数[math]\boldsymbol{X}[/math]を確率変数ではなく確定値としているところです。これから紹介する性質は説明変数が確率変数の場合には一般には成立しません。説明変数を実験者がコントロールできる場合は妥当な仮定ですが

- 説明変数、目的変数ともに他の変数を介して関連する場合

- 結果から要因を解析する場合

などはこの仮定が成立しなくなるので注意が必要です。

最小二乗推定量

学習データ[math](\boldsymbol{X}, \boldsymbol{y})[/math]を[math]\hat{y} = \boldsymbol{\hat{\beta}}^T\boldsymbol{x}[/math]で当てはめた時と同様に回帰係数[math]\boldsymbol{\beta}[/math]の推定量を

[math]

\boldsymbol{\hat{\beta}} = \left(\boldsymbol{X}^T\boldsymbol{X}\right)^{-1}\boldsymbol{X}^T\boldsymbol{Y}

[/math]

で定義し最小二乗推定量やOLS(Ordinal Least Square)推定量と呼びます。

不偏性

最小二乗推定量[math]\boldsymbol{\hat{\beta}}[/math]は不偏性を持っていることを確認しましょう。

[math]

\begin{eqnarray}

E\left[\boldsymbol{\hat{\beta}}\right] &=& E\left[\left(\boldsymbol{X}^T\boldsymbol{X}\right)^{-1}\boldsymbol{X}^T\boldsymbol{Y}\right] \\

&=& \left(\boldsymbol{X}^T\boldsymbol{X}\right)^{-1}\boldsymbol{X}^TE[\boldsymbol{X}\boldsymbol{\beta}+\boldsymbol{\varepsilon}] \\

&=& \left(\boldsymbol{X}^T\boldsymbol{X}\right)^{-1}\boldsymbol{X}^T\boldsymbol{X}\boldsymbol{\beta} \\

&=& \boldsymbol{\beta}

\end{eqnarray}

[/math]

となるので最小二乗推定量[math]\boldsymbol{\hat{\beta}}[/math]は[math]\boldsymbol{\beta}[/math]の不偏推定量になります。

ガウス・マルコフの定理

最小二乗推定量[math]\boldsymbol{\hat{\beta}}[/math]は最良線形不偏推定量になることが知られており「ガウス・マルコフの定理」と呼ばれます。

[math]

Cov\left[\boldsymbol{\tilde{\beta}}\right] \succeq Cov\left[\boldsymbol{\hat{\beta}}\right]

[/math]

が成立する。つまり最小二乗推定量[math]\boldsymbol{\hat{\beta}}[/math]は最良線形不偏推定量になる。

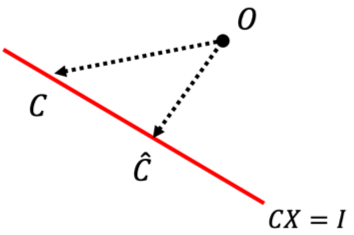

[math]\boldsymbol{\tilde{\beta}}[/math]を任意の線型推定量とすると[math]\boldsymbol{C}\in\mathbb{R}^{(P+1)\times N}[/math]を用いて

[math]

\boldsymbol{\tilde{\beta}} = \boldsymbol{C}\boldsymbol{Y}

[/math]

とかけます。この推定量が[math]\boldsymbol{\beta}[/math]の不偏推定量になるための条件を求めると

[math]

\begin{eqnarray}

E\left[

\boldsymbol{\tilde{\beta}}\right] &=& \boldsymbol{C}\boldsymbol{X}\boldsymbol{\beta} \\

&=& \boldsymbol{\beta}

\end{eqnarray}

[/math]

が恒等的に成立するので[math]\boldsymbol{C}\boldsymbol{X}=\boldsymbol{I}[/math]になります。

次に分散共分散行列を整理すると

[math]

\begin{eqnarray}

Cov\left[

\boldsymbol{\tilde{\beta}}\right] &=& E\left[(\boldsymbol{C}\boldsymbol{Y}-\boldsymbol{\beta})(\boldsymbol{C}\boldsymbol{Y}-\boldsymbol{\beta})^T\right] \\

&=& E\left[\boldsymbol{C}\boldsymbol{\varepsilon}(\boldsymbol{C}\boldsymbol{\varepsilon})^T\right] \\

&=& \boldsymbol{C}E[\boldsymbol{\varepsilon}\boldsymbol{\varepsilon}^T]\boldsymbol{C}^T \\

&=& \sigma^2\boldsymbol{C}\boldsymbol{C}^T

\end{eqnarray}

[/math]

になります。[math]\boldsymbol{\hat{C}}=\left(\boldsymbol{X}^T\boldsymbol{X}\right)^{-1}\boldsymbol{X}^T[/math]の時の推定量が最小二乗推定量[math]\boldsymbol{\hat{\beta}}[/math]になるので[math]\boldsymbol{C}\boldsymbol{C}^T \succeq \boldsymbol{\hat{C}}\boldsymbol{\hat{C}}^T[/math]を示せば良いです。

ここでも「直交性」を使って示します。[math]\boldsymbol{C}\boldsymbol{X}=\boldsymbol{I}[/math]を満たす[math]\boldsymbol{C}[/math]に対して

[math]

\begin{eqnarray}

\left(\boldsymbol{C}-\boldsymbol{\hat{C}}\right) \boldsymbol{\hat{C}}^T &=& \left

(\boldsymbol{C}-\boldsymbol{\hat{C}}\right)\boldsymbol{X}(\boldsymbol{X}^T\boldsymbol{X})^{-1} \\

&=& \left

(\boldsymbol{C}\boldsymbol{X}-\boldsymbol{\hat{C}}\boldsymbol{X}\right)(\boldsymbol{X}^T\boldsymbol{X})^{-1} \\

&=& \boldsymbol{O}

\end{eqnarray}

[/math]

が成立するので

[math]

\begin{eqnarray}

\boldsymbol{C}\boldsymbol{C}^T &=&

\left(\boldsymbol{C}-\boldsymbol{\hat{C}}+\boldsymbol{\hat{C}}\right)\left(\boldsymbol{C}-\boldsymbol{\hat{C}}+\boldsymbol{\hat{C}}\right)^T \\

&=& \left(\boldsymbol{C}-\boldsymbol{\hat{C}}\right)\left(\boldsymbol{C}-\boldsymbol{\hat{C}}\right)^T + \boldsymbol{\hat{C}}\boldsymbol{\hat{C}}^T \\

&\succeq& \boldsymbol{\hat{C}}\boldsymbol{\hat{C}}^T

\end{eqnarray}

[/math]

となります。これより

[math]

Cov\left[\boldsymbol{\tilde{\beta}}\right] \succeq Cov\left[\boldsymbol{\hat{\beta}}\right]

[/math]

が成立し最小二乗推定量[math]\boldsymbol{\hat{\beta}}[/math]は最良線形不偏推定量になることがわかります。

シリーズ記事

「機械学習」の「教師あり学習手法」の中で最も基本的な手法として「重回帰」の性質を紹介しています。

ここでは誤差項が「無相関で分散一定」を仮定すると

最小二乗推定量は最良線形不偏推定量になる

ことを示しました。「最尤推定量」以降の記事では誤差項が「独立同一な正規分布」を仮定し様々な性質を導いていきます。

また行列やベクトル演算が多く何をしているか理解しづらいと感じた方は説明変数が1つの場合である「単回帰」も参照ください。

脚注

| ↑1 | ここでの議論は無相関性を仮定すれば成立し、独立性の仮定は不要です。 |

|---|

「有意に無意味な話」回帰分析に関連する部分を数多く拝見させて頂きました。

回帰分析のごちゃごちゃしているところを非常にすっきりと良くまとめられておられると思いました。

ヘッセ行列が射影になっていること、ヘッセ行列を直交写像で映した先で値1か0の固有値が現れ、カイ二乗分布の自由度が現れることなど見て取れ、大変に感動しました。

ヘッセ行列ではなくハット行列でした(汗)