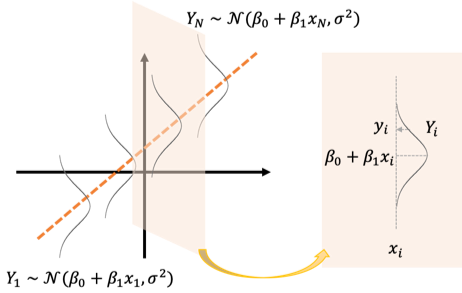

ここからは誤差項が正規分布に従うモデルを考えます。

[math]

Y_i = \beta_0 + \beta_1 x_i + \varepsilon_i,\ \varepsilon_i \sim \mathcal{N}(0, \sigma^2)

[/math]

具体的な確率分布を仮定するため最尤推定量を求めることができます。ここでは最尤推定量は最小二乗推定量と一致することを示します。

確率モデル

ここでは目的変数[math]Y_i[/math]と説明変数[math]x_i[/math]の間に

[math]

Y_i = \beta_0 + \beta_1 x_i + \varepsilon_i,\quad i=1,\dots,N

[/math]

の関係があり誤差項[math]\varepsilon_i[/math]は独立で同一の正規分布[math]\mathcal{N}(0, \sigma^2)[/math]に従うと仮定します。

確率変数[math]Y_i[/math]の観測値を[math]y_i[/math]とします。確率モデルは何が確率変数で何が確定値なのかわかりにくいのでまとめると

- [math]x_i,\ y_i[/math]: 既知の確定値

- [math]\beta_0,\ \beta_1,\ \sigma^2[/math]: 未知の確定値

- [math]Y_i,\ \varepsilon_i[/math]: 確率変数

になります。

なお、この確率モデルでは誤差が「無相関」かつ「分散一定」になるので「ガウス・マルコフの定理」が成立し最小二乗推定量は最良線形不偏推定量になります。

最尤推定量

確率変数[math]Y_i[/math]は仮定より独立で正規分布[math]\mathcal{N}(\beta_0 + \beta_1 x_i, \sigma^2)[/math]に従います。

正規分布[math]\mathcal{N}(\mu, \sigma^2)[/math]の確率密度関数を[math]f(y|\mu, \sigma^2)[/math]とすると

[math]

f(y|\mu, \sigma^2) = \dfrac{1}{\sqrt{2\pi\sigma^2}}\exp\left[-\dfrac{(y – \mu)^2}{2\sigma^2}\right]

[/math]

で与えられます。これより対数尤度関数[math]\log L[/math]を求めると

[math]

\begin{eqnarray}

&& \log L(\beta_0, \beta_1, \sigma^2 | y_i) \\

&=& \log \prod_{i=1}^N f(y_i|\beta_0 + \beta_1 x_i, \sigma^2) \\

&=& -\dfrac{N}{2}\log \sigma^2-\dfrac{1}{2\sigma^2}\sum_{i=1}^N\left(y_i – \beta_0 – \beta_1 x_i\right)^2 + C

\end{eqnarray}

[/math]

となります。ここで[math]C[/math]は定数です。

尤度が最大になる[math]\beta_0, \beta_1, \sigma^2[/math]を求めるために

[math]

\begin{cases}

\dfrac{\partial (\log L)}{\partial \beta_0} = 0 \\

\dfrac{\partial (\log L)}{\partial \beta_1} = 0 \\

\dfrac{\partial (\log L)}{\partial \sigma^2} = 0

\end{cases}

[/math]

の第1式、第2式を整理すると

[math]

\begin{eqnarray}

&&\sum_{i=1}^N \left(y_i – \beta_0 – \beta_1 x_i \right) = 0 \\

&&\sum_{i=1}^N x_i\left(y_i – \beta_0 – \beta_1 x_i \right) = 0

\end{eqnarray}

[/math]

と「基本的な性質」の最小二乗法で解いた時とまったく同じ方程式が得られます。

したがって[math]\beta_0, \beta_1[/math]の最尤推定量は最小二乗推定量と一致し

[math]

\begin{eqnarray}

\hat{\beta}_1 &=& \dfrac{1}{S_{xx}}\sum_{i=1}^N (x_i – \bar{x})(Y_i – \bar{Y}) \\

\hat{\beta}_0 &=& \bar{Y} – \hat{\beta}_1\bar{x}

\end{eqnarray}

[/math]

で与えられます。ここで[math]\bar{x}=\frac{1}{N}\sum_{i}x_i[/math], [math]\bar{Y}=\frac{1}{N}\sum_{i}Y_i[/math], [math]S_{xx} = \sum_i (x_i – \bar{x})^2[/math]です。

最後に[math]\sigma^2[/math]の最尤推定量は[math]\partial (\log L)/ \partial \sigma^2 = 0[/math]を解いて

[math]

\hat{\sigma}^2 = \displaystyle\dfrac{1}{N}

\sum_{i=1}^N\left(Y_i – \hat{\beta}_0 – \hat{\beta}_1 x_i\right)^2

[/math]

で与えられます。

シリーズ記事

「機械学習」の「教師あり学習手法」の中で最も基本的な手法として「単回帰」の性質を紹介しています。

ここでは誤差項が「独立同一な正規分布」に従うと仮定すると導ける性質として

- 最尤推定量(本記事): 最尤推定量は最小二乗推定量と一致

- 誤差の正規性チェック

- 回帰係数の有意性: 最小二乗推定量の確率分布と有意性検定を導出

- 信頼区間: 真の値の推定値が従う確率分布から信頼区間を導出

- 予測区間: 観測値が従う確率分布から予測区間を導出

を解説しています。

また単回帰を拡張した「重回帰」でも同様の性質を示せるのでそちらも参照ください。